Ile megabajtów w gigabajtach?

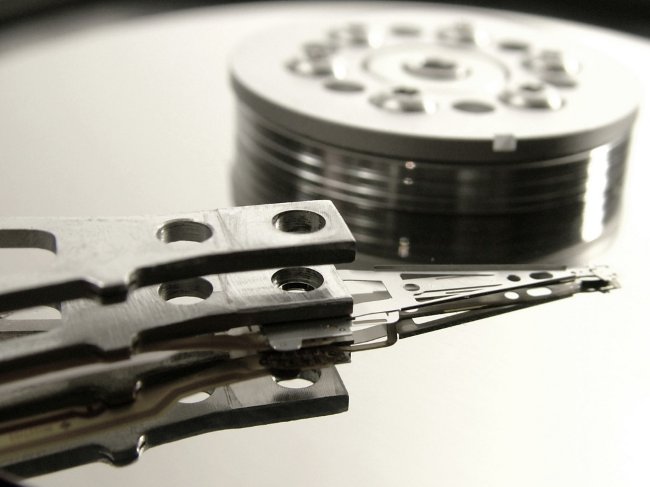

Wielu użytkowników napotkało nie za dużoprzyjemna sytuacja: kupujesz dysk głośność napędu, na przykład, 500 GB, podłącz go do komputera i dowiedzieć się, co jest dostępne około 480 gigabajtów. A wszystko z powodu, że producenci dysków twardych uważają, że GIGABYTE 1000 megabajtów, a pewność, że system Windows 1024. Kto ma rację? Ile megabajtów w gigabajtach?

Wielu użytkowników napotkało nie za dużoprzyjemna sytuacja: kupujesz dysk głośność napędu, na przykład, 500 GB, podłącz go do komputera i dowiedzieć się, co jest dostępne około 480 gigabajtów. A wszystko z powodu, że producenci dysków twardych uważają, że GIGABYTE 1000 megabajtów, a pewność, że system Windows 1024. Kto ma rację? Ile megabajtów w gigabajtach? Głównym problemem jest to Ilość informacji może być mierzona zarówno w systemie binarnym, jak i dziesiętnym. Ponadto istnieją różne standardy jednostek miar do pomiaru ilości informacji. Powoduje to zamieszanie i utrudnia dokładne określenie liczby megabajtów w gigabajtach.

Właściwie przedrostki "kilo", "mega", "giga-" itd. są używane w Międzynarodowym Systemie Jednostek (SI) i oznaczają moce liczby dziesięć. Dlatego, jeśli myślisz logicznie, w jednym gigabajmie powinno być 1000 megabajtów. Ale dlaczego twój system operacyjny jest pewny, że jest ich 1024?

Faktem jest, że Twórcy wielu nowoczesnych systemów operacyjnych korzystają ze standardowej pamięci JEDEC 100B.01 (standard Wspólnej Rady Inżynieryjnej dlaurządzenia elektroniczne), zgodnie z którymi prefiksy akceptowane w systemie SI mogą oznaczać nie potęgę dziesięciu, ale potęgę dwóch (to znaczy, że w standardzie nie wykorzystuje się systemu dziesiętnego, lecz binarnego). Dlatego jeden gigabajt według standardowego JEDEC będzie równy 1024 megabajtom.

Producenci używają dysków twardych i dysków flash Normy przyjęte przez Międzynarodową Komisję Elektrotechniczną (IEC). Zgodnie z tymi standardami, prefiksy SI są używane do oznaczania stopni numer dziesięć. Dlatego jeden gigabajt powinien wynosić 1000 megabajtów i nie więcej megabajtów. GOST 8.417-2002, regulując nazwy jednostek miary na terytorium Rosji, również przylega do tego punktu widzenia.

Jeśli ważne jest podkreślenie, że mówimy o systemie liczb dwójkowych, Nie trzeba używać przedrostki dziesiętne i binarne (binarne). W tym przypadku 1024 bajty będą równe jednemu kibibyte, 1024 kibibytom na jeden mebibit, 1024 mebibytom na jeden gibi-bajt. Są to binarne załączniki przyjęte w standardzie IEC.

Problem polega na tym załączniki binarne, chociaż są poprawne, ale praktycznie nie są używane. Po pierwsze, historycznie okazało się, żeKonsole dziesiętne służą do oznaczania jednostek ilości informacji w systemie dwójkowym. Po drugie, konsole binarne po prostu nie są zbyt eufonistyczne.

Więc zwykły użytkownik raczej się nie spotkajednostka miary "gibibajta", ponieważ prawie nikt jej nie używa. I jak to określić, ile megabajtów za gigabajt w tym konkretnym przypadku - w 1000 lub 1024? Należy zwrócić uwagę na pisanie jednostki do pomiaru ilości informacji.

Zgodnie z propozycją IEC, jeśli podano binarny kilobajt / megabajt / gigabajt, notacja musi rozpoczynać się wielką literąna przykład GB, Gbyte, GB. To oznaczenie wskazuje, że gigabajt w tym przypadku to 1024 megabajty. Jeśli pierwsza litera w zapisie jest mała (gbyte, gbyte, gb), mamy na myśli dziesiętny ("komercyjny") gigabajt składający się z 1000 megabajtów.

Jak widać, w oznaczeniu jednostek miary objętości informacji, dziesiętne przedrostki SI, które są używane nawet w tych przypadkach, w których standard IEC powinien używać prefiksów binarnych. Dlatego w gigabajtach okazuje się, że jest 1000, a następnie 1024 megabajtów.

Najłatwiej o tym pamiętać Producenci dysków twardych i dysków flash używają "poprawnych" gigabajtów, dziesiętnie. Oraz producenci pamięci RAM,pamięć wideo, płyty CD, a także Microsoft i Apple (odpowiednio programiści systemów operacyjnych Windows i Mac OS X), a twórcy oprogramowania korzystają z binarnych gigabajtów zawierających 1024 megabajty (które można nazwać gibibytami i mebibytami).